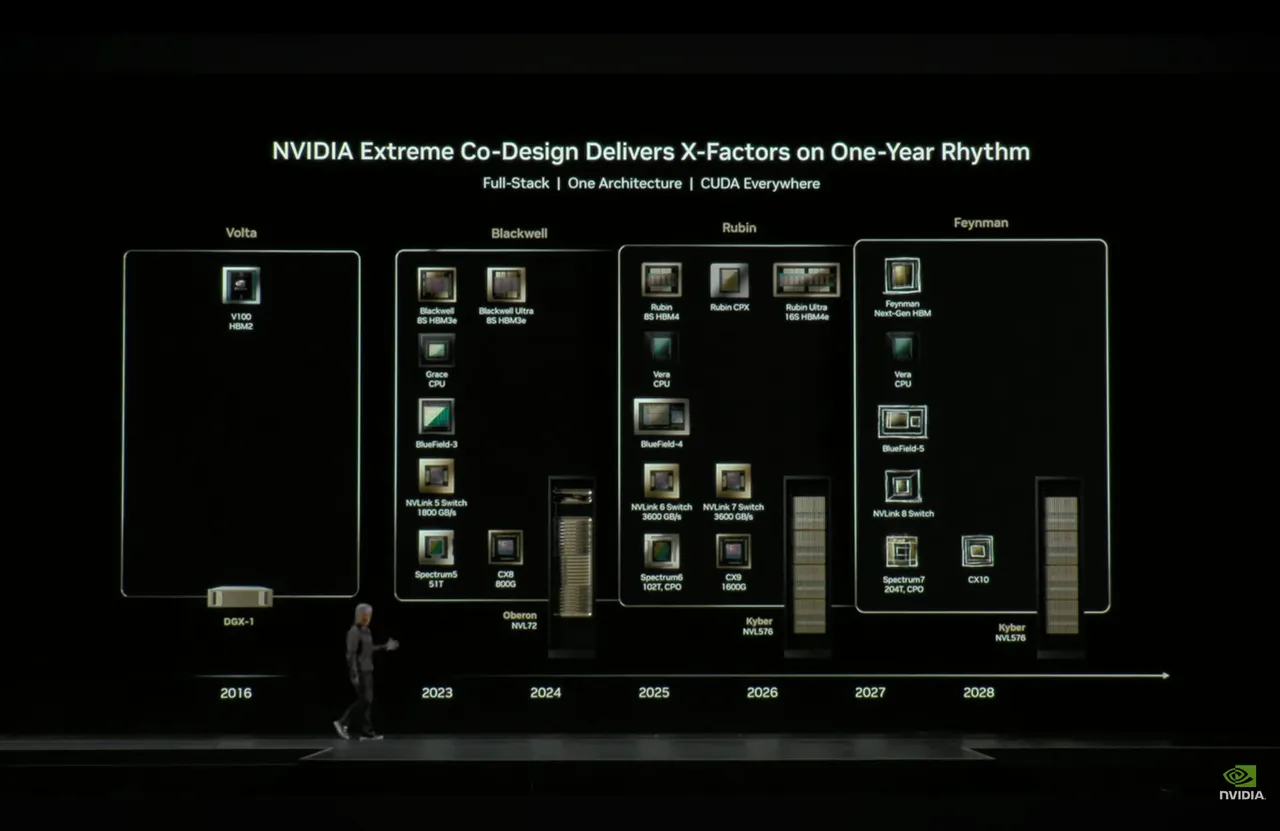

辉达指出,Rubin GPU 已回到实验室进行验证,为台积电代工的首批样品。单颗 Rubin 采 2 颗 reticle 尺寸 GPU 核心,并配有 8 颗 288GB HBM4,将来到总计 100 PFLOPS 的算力。Vera CPU 采 88 颗客制化 Arm 核心、176 执行绪,两者以 NVLINK-C2C 1.8TB/s 高频宽互连,同时可以看到 CPU 两侧搭配 LPCAMM2 或 SODIMM2 记忆体模组插槽。黄仁勋更是大赞这款超级晶片机架系统设计,将不再使用传统的缆线连接,而是改为插槽,同时完全采用液冷,有助于简化 AI 伺服器内结构、组装与升级散热管理。

时程与定位方面,黄仁勋预计,Vera Rubin NVL144 平台将于 2026 年下半年量产上线,衔接并迭代现行 Blackwell GB300 平台的机柜级部署。在同一机柜容量下,Vera Rubin NVL144 可提供双倍 NVLINK 与 CX9 的通讯能力(最高分别为260 TB/s与28.8 TB/s),相较 GB300 ,可实现FP4 推理与FP8 训练的算力,同时显著强化机架内外带宽与可扩充性。

黄仁勋说明,往下一阶段来看,将于 2027 年推出 Rubin Ultra NVL576,CPU 架构不变,GPU 升级为 4 颗 reticle 尺寸核心,并规划于 2028 年推出下一代 GPU 架构 Feynman 平台,不过 CPU 仍采用 Vera,维持 GPU 改版 2 次、CPU 改版 1 次的迭代节奏。与 Rubin Ultra 同时推出的还有新一代机架系统 Kyber NVL576,同样延续至 Feynman 平台。

黄仁勋也在同场演讲提到,亚马逊、CoreWeave、Google、Meta、微软与甲骨文等云端服务(CSP)巨头正迎来新一轮资本支出扩张期,利用辉达GB200 NVL72平台,生产最高 Token 产生效率、最低 TCO 回应这波AI超级扩张需求,并确保服务在使用高峰期也能维持速度与效能。

黄仁勋分析,AI进入了新的扩展阶段,从预训练、后训练再到推论,等三阶段全部开始运作后,AI模型需要更即时计算,而非单纯调度资源,届时运算需求将以指数型成长,资料中心也从传统通用架构走向全加速运算。

黄仁勋强调,CSP透过 GB200 取得十倍效能与成本下降,才能让 AI 应用的正向循环持续转动,推动更多需求再回到更大规模的算力投资。

點擊閱讀下一則新聞

點擊閱讀下一則新聞