供应链方面, NVIDIA RTX PRO 伺服器提供多种配置,合作伙伴涵盖Cisco、Dell Technologies、HPE、Lenovo 与 Supermicro,以及研华、安提国际、Aivres、永擎电子、华硕、仁宝、Eviden、鸿海科技集团、技嘉、英业达、神达电脑、微星、和硕联合科技、云达、纬创及纬颖等。

云端服务供应商 CoreWeave 和 Google Cloud 现已提供由 NVIDIA RTX PRO 6000 Blackwell 伺服器版 GPU 加速的运算执行个体,AWS、Nebius 和 Vultr 也将于今年稍晚推出更多相关执行个体。

相关新闻:辉达推RTX PRO伺服器!鸿海、台积电等大厂抢先采用 揭AI应用蓝图

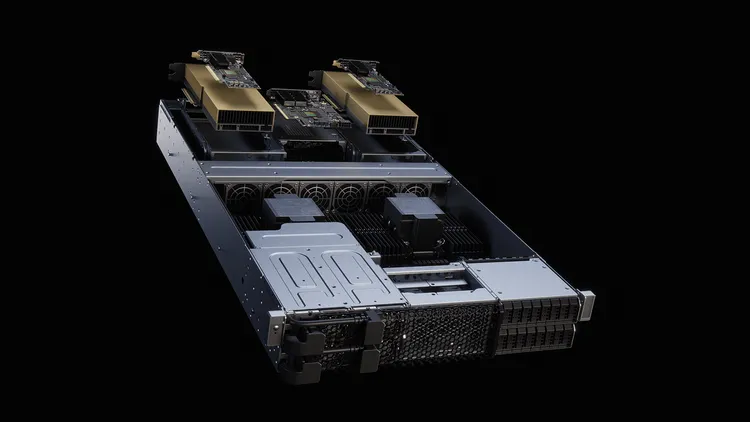

辉达表示, NVIDIA RTX PRO 伺服器能加速代理型 AI 与推理工作负载,协助研究人员与开发者建构并部署具备即时学习、适应与互动能力的自主系统。例如,NVIDIA Llama Nemotron Super 推理模型在单颗 RTX PRO 6000 GPU 上以 NVFP4 运行时,相较于 H100 GPU 以 FP8 运行,性价比最高可提升 3 倍,能以更低成本实现更准确的推理。为了开发高效的物理 AI 系统,企业可先在模拟环境中测试与最佳化机器人车队,再部署至实际工厂; NVIDIA RTX PRO 伺服器在数位孪生、模拟与合成资料生成等工作流程中,效能较搭载 L40S GPU 的系统提升最多达 4 倍,推动工业 AI 与物理 AI 发展。

NVIDIA RTX PRO 伺服器以最大化弹性为设计核心,支援 Windows、Linux 与主流虚拟机器管理程式,让 IT 管理人员可在不影响效能的情况下大规模部署 AI。其采用风冷、基于 PCIe 的 x86 架构,几乎能执行所有企业级工作负载,并具备安全性、可管理性与可维护性,确保企业能以熟悉的环境快速升级至 AI 世代。

NVIDIA RTX PRO 伺服器与整个 Blackwell 架构产品组合,皆由 NVIDIA AI Enterprise 软体平台支援,内含 NVIDIA NIM 微服务及多样 AI 框架、程式库与工具,让企业可在云端、资料中心与工作站上部署。

NVIDIA RTX PRO 伺服器已纳入 Enterprise AI Factory 验证设计,适用于希望在本地建构 AI 工厂的企业,并整合于 NVIDIA AI 资料平台,作为可客制化的参考设计,用于打造现代化储存系统,以支援企业级代理型 AI。同时,RTX PRO 伺服器结合 Omniverse 程式库与 Cosmos 世界基础模型,能协助物理 AI 开发者建构并部署各类应用,包括工厂与机器人模拟的数位孪生,或大规模合成资料生成。

點擊閱讀下一則新聞

點擊閱讀下一則新聞