辉达表示,预计由合作伙伴包括Cisco、Dell Technologies、Hewlett Packard Enterprise、Lenovo及美超微电脑(Supermicro)将推出基于Blackwell Ultra的伺服器;此外,Aivres、ASRock Rack、华硕、Eviden、鸿海、技嘉、英业达、和硕、广达旗下云达科技(QCT)、纬创及纬颖等公司也将参与其中。

辉达说明,包括北美大型云端服务商Amazon Web Services、Google Cloud、Microsoft Azure及Oracle Cloud Infrastructure,与GPU云服务商CoreWeave、Crusoe、Lambda、Nebius、Nscale、Yotta和YTL等也将是首批获得Blackwell Ultra平台的公司。

NVIDIA GB300 NVL72连接72个Blackwell Ultra GPU和36个基于Arm Neoverse架构的NVIDIA Grace CPU,采用机架级设计,作为一个巨型GPU,专为推理阶段扩展而设。通过GB300 NVL72,AI模型能够利用平台的增强计算能力,探索不同的解决方案,将复杂的请求分解为多个步骤,从而提供更高品质的回应。

GB300 NVL72预计将在NVIDIA DGX Cloud上提供,这是一个端对端、全管理的AI平台,专为不断演变的工作负载优化性能,并结合软体、服务及AI专业知识。搭载DGX GB300系统的NVIDIA DGX SuperPOD使用GB300 NVL72机架设计。

NVIDIA HGX B300 NVL16相比于Hopper世代,提供11倍更快的推理性能、7倍更多计算资源与4倍更大的内存,为最复杂的工作负载(如AI推理)提供突破性性能。

Blackwell Ultra系统无缝整合了NVIDIA Spectrum-X以太网和NVIDIA Quantum-X800 InfiniBand平台,为每个GPU提供高达800 Gb/s的数据吞吐量,并通过NVIDIA ConnectX-8 SuperNIC实现远端直接内存存取,帮助AI工厂和云端数据中心处理AI推理模型,无需担心瓶颈问题。

NVIDIA BlueField-3 DPU也被纳入Blackwell Ultra系统中,支持多租户网络、GPU计算弹性、加速数据存取及即时网络安全威胁检测。

辉达表示,GB300 NVL72在使用DeepSeek-R1的AI模型可以每秒处理 1,000 个 Token ,使用 Hopper每秒处理 100 个 Token,代表GB300 NVL72可以使用10秒时间回答问题,但是Hopper要花费1.5分钟。

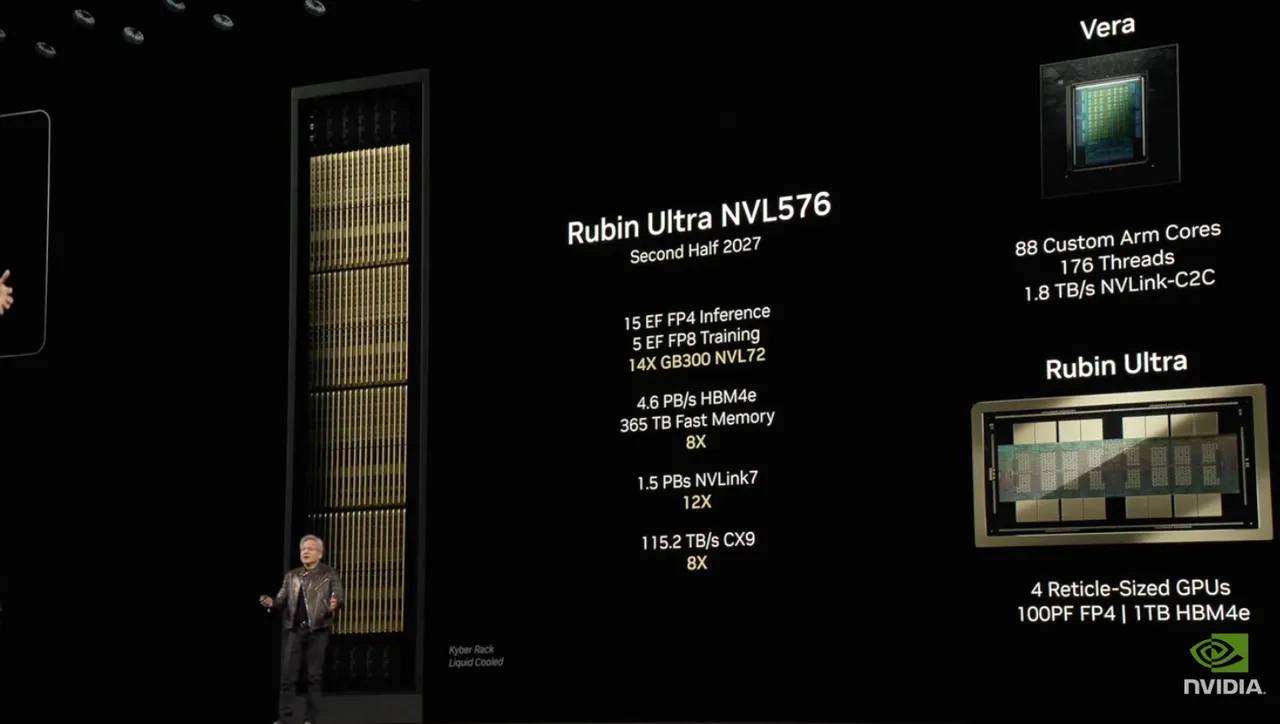

此外,黄仁勋也公布继Hopper、Blackwell 之后的新一代GPU架构Rubin,以及搭配的CPU架构Vera。从资料图来看,Vera Rubin采用288GB HBM4,从GB300 NVL72升至Vera Rubin NVL144,Vera记忆体是Grace的4.2 倍,记忆体频宽将是Grace 的 2.4 倍,达88个CPU 核心,预计2026年下半年推出。黄仁勋也更进一步宣布,2027年下半年将推出Vera Rubin Ultra,由4个GPU整合而成,来到1TB HBM4e,且来到Rubin Ultra NVL576,声称性能是Hopper的900倍,相比之下,Blackwell则是Hopper的68倍。

點擊閱讀下一則新聞

點擊閱讀下一則新聞