NVIDIA执行长黄仁勋表示,AI 正首次改写过去 60 年来的运算模式,从云端延伸到本地资料中心,带动架构全面变革。透过与全球领先伺服器供应商合作,RTX PRO 伺服器将成为企业与工业 AI 的标准平台。

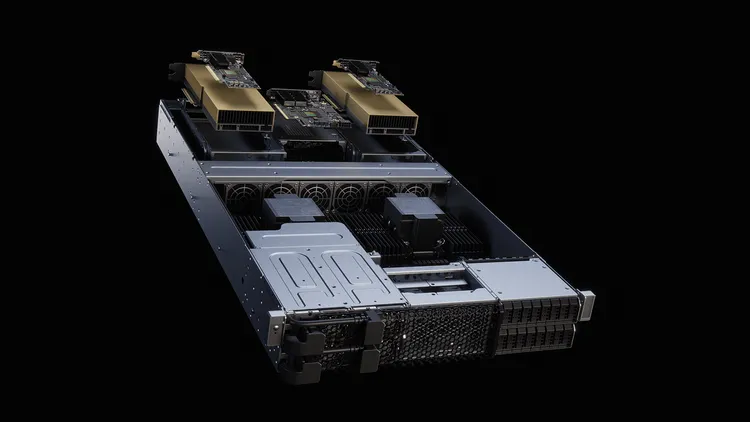

NVIDIA RTX PRO 伺服器将 GPU 加速应用扩展至资料分析、模拟、影像处理与渲染等传统 CPU 型工作负载,相较纯 CPU 的 2U 系统,效能最高可提升 45 倍、能源效率提升 18 倍,并降低总持有成本。对于在空间、耗能与冷却条件受限的资料中心,这款新系统可大幅提升运算密度与 AI 部署能力,成为打造「AI 工厂」的核心基础架构。

技术规格方面,RTX PRO 6000 Blackwell 采用第五代 Tensor 核心与第二代 Transformer 引擎,支援 FP4 精度,推论效能最高较上一代 L40S GPU 提升 6 倍;第四代 RTX 技术则将渲染效能提升至 4 倍。多使用者环境可透过 NVIDIA 多执行个体 GPU(MIG)技术,将单颗 GPU 分割为最多四个独立执行个体,兼顾安全性与弹性部署。

针对物理 AI 与机器人应用,RTX PRO 伺服器支援 NVIDIA Omniverse 函式库与 NVIDIA Cosmos 世界基础模型,可加速数位孪生建模与大规模合成资料生成,模拟速度较 L40S GPU 提升至 4 倍。此外,也整合 NVIDIA Metropolis 平台的最新蓝图,包括视讯搜寻与摘要功能、视觉语言模型与合成资料扩充,提升空间安全性与生产力。

所有 RTX PRO 伺服器均通过 NVIDIA AI Enterprise 认证,并适合部署 AI 推理代理模型,例如刚发布的 Llama Nemotron Super,在单颗 RTX PRO 6000 GPU 上以 NVFP4 技术执行,其性价比最高可达 H100 GPU 的 FP8 技术 3 倍。Blackwell 平台结合 CUDA-X 程式库、生态系超过 600 万名开发者与近 6,000 个应用,将效能延伸至数千颗 GPU。

全球系统制造商 Cisco、Dell、HPE、Lenovo 与 Supermicro 将推出多款 NVIDIA 认证的 RTX PRO 伺服器,其他合作伙伴还包括研华、安提国际、Aivres、永擎电子、华硕、仁宝、鸿海科技集团、技嘉科技、英业达、神云科技、微星科技、和硕、云达科技、纬创资通与纬颖。客户即日起可透过上述系统制造商与通路伙伴订购 RTX PRO 伺服器,目前采八颗 RTX PRO 6000 GPU 配置的 4U 机型已开放选购,2U 主流机型则预计于今年稍晚上市。

點擊閱讀下一則新聞

點擊閱讀下一則新聞